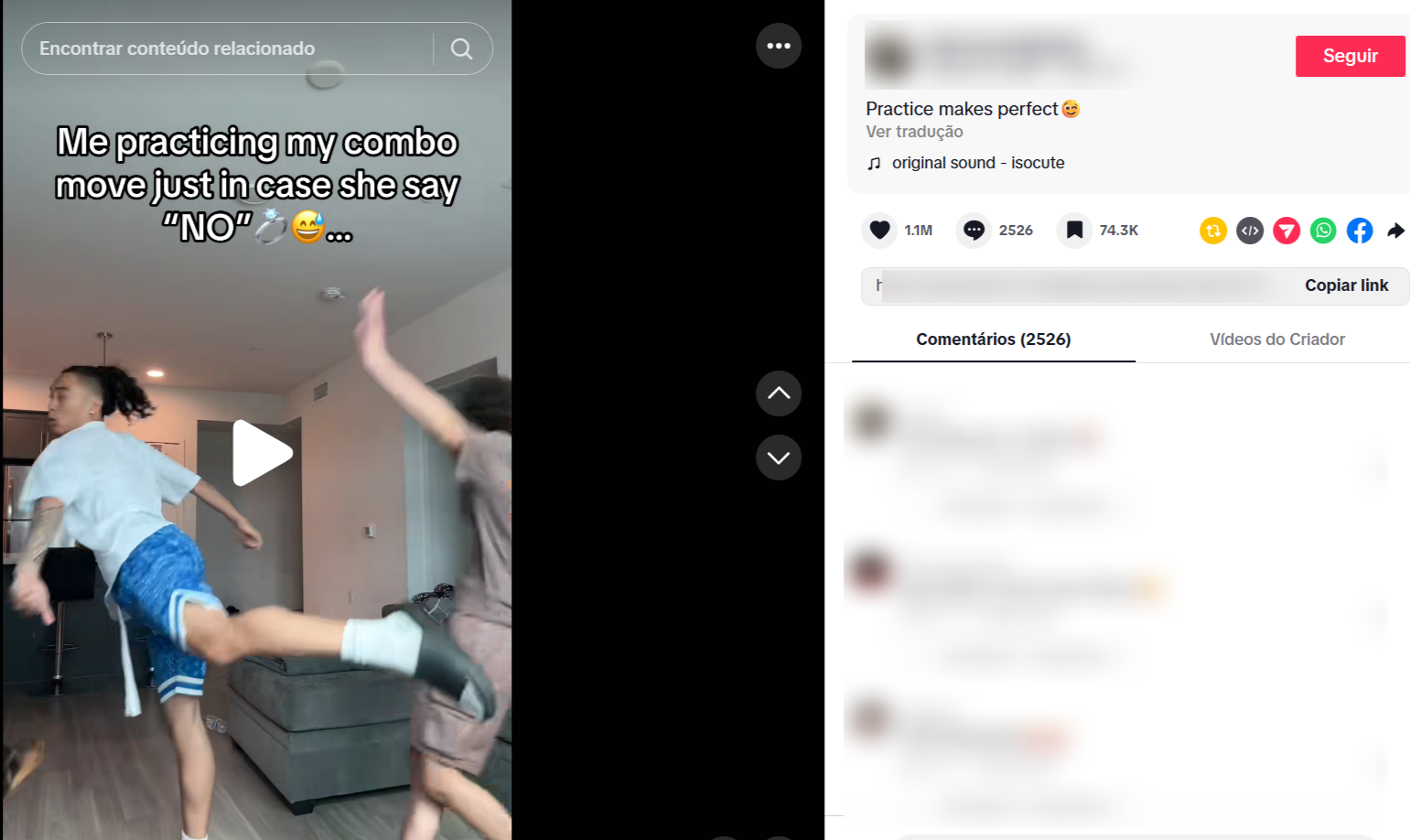

Trend 'Caso ela diga não' estimula violência contra as mulheres e vira caso de polícia A Polícia Federal (PF) abriu um inquérito para investigar a divulgação nas redes sociais da trend "Caso ela diga não", que incita a violência contra mulheres. Os vídeos, que viralizaram no TikTok, mostram jovens ensinando como responder uma mulher diante de uma rejeição, como a recusa de um pedido de namoro, por exemplo. Eles aparecem dando socos e chutes em manequins que representariam mulheres. Segundo a PF, a remoção dos conteúdos já foi solicitada à plataforma. O TikTok afirmou que os conteúdos violam as regras da plataforma e que foram removidos após serem identificados. As publicações vieram à tona dias depois de um outro caso gerar revolta no país: uma adolescente de 17 anos denunciou ter sido vítima de um estupro coletivo no Rio de Janeiro. De acordo com a denúncia, o ataque ocorreu em 31 de janeiro, em um apartamento em Copacabana, e foi classificado pela polícia como "emboscada planejada". Segundo as investigações, a adolescente foi convidada por mensagem pelo ex-namorado para ir à casa de um amigo. Ao chegarem ao prédio, ele teria insinuado que fariam "algo diferente", proposta recusada por ela. De acordo com a adolescente, enquanto mantinham uma relação sexual consensual, outros quatro rapazes entraram no quarto, cometendo violências sexuais e físicas contra ela. Imagens exibidas pelo Fantástico, da TV Globo, mostraram os cinco jovens acusados de envolvimento no estupro comemorando o acontecido e debochando da vítima. Nas imagens, eles aparecem rindo e conversando no elevador, após deixar o apartamento. "A mãe de alguém teve que chorar hoje, porque as nossas mães..." Vídeo no elevador expõe deboche após estupro coletivo em Copacabana A Justiça decretou a prisão preventiva de quatro jovens. Um menor foi apreendido. Os réus negam o crime. Ao se apresentar na delegacia na última semana, um dos investigados por participar do estupro, Vitor Hugo Oliveira Simonin, de 18 anos, usava uma camisa com a frase em inglês "regret nothing" ("não me arrependo de nada", na tradução para o português). A expressão é frequentemente associada a grupos da chamada "machosfera", comunidades online que propagam misoginia e subjulgação das mulheres. 'Regret nothing': frase de réu por estupro coletivo expõe cultura misógina Nos últimos anos, essas comunidades ganharam visibilidade ao promover narrativas que culpabilizam mulheres por relações afetivas frustradas, defendem hierarquias de gênero e, em alguns casos, incentivam comportamentos violentos. Esse fenômeno preocupa pesquisadores, que identificam uma reversão nas atitudes dos homens mais jovens em relação às mulheres — e apontam as redes sociais como motor dessa mudança. Segundo um estudo global realizado pela empresa de pesquisas Ipsos e pelo King's College de Londres, os homens da geração Z — nascidos entre 1996 e 2012 — têm mais propensão do que os baby boomers — nascidos entre 1945 e 1965 — a acreditar que as esposas devem "obedecer" seus maridos. O estudo envolveu 23 mil pessoas de 29 países e demonstrou que até 31% dos homens adolescentes e na casa dos 20 anos de idade acreditam que "a esposa deve sempre obedecer seu marido", enquanto 13% dos homens mais velhos, com 60 anos ou mais, concordam com esta mesma afirmação. Em entrevista à BBC News, a professora Heejung Chung, que dirige o Instituto Global para a Liderança das Mulheres do King's College de Londres, disse não há dúvidas que as redes sociais desempenham "enorme papel" na mudança de opinião. Isso ocorre, segundo ela, porque os influenciadores e políticos "exploram as reclamações das pessoas" e "tentam recapturar parte do sentimento de serem enfraquecidos pela geração mais jovem". Eles fazem isso sugerindo que os homens precisam reafirmar sua dominância e seu papel de protetores e provedores, explica Chung, que é uma das autoras do estudo. "As pessoas estão imitando o que veem nas redes sociais sem realmente compreender o que aquilo significa." Penny East, executiva-chefe da Sociedade Fawcett — uma organização de defesa dos direitos das mulheres com sede no Reino Unido — concorda. Para ela, os "níveis chocantes de misoginia, online e offline", a que os meninos são expostos contribuem para essas atitudes. "É quase surpreendente que os meninos possam não assumir esse comportamento misógino, considerando o conteúdo oferecido a eles diariamente em termos do que eles consomem na internet", afirmou. 'Tudo indo na direção errada' O número de mulheres mais jovens que acreditam que as esposas devem obedecer aos seus maridos foi menor que o de homens na pesquisa, mas esta proporção ainda era mais alta que a dos homens da geração baby boomer. Questionada sobre qual poderia ser o motivo, East aponta novamente as redes sociais. "Da mesma forma que os homens jovens são ensinados que o caminho para a felicidade é o dinheiro, carros, garotas e força física, existem mulheres sendo ensinadas que o caminho para a felicidade é a ideia tradicional de feminilidade", explica ela. "Parte disso é o conteúdo esteticamente agradável que mostra a 'esposa tradicional', que fica na cozinha. Mas existe um lado mais sombrio, que se refere à subserviência... Se o homem é o provedor, ele, por isso, manda na casa?", pergunta ela, retoricamente. "Parece simplesmente que tudo está indo na direção errada", lamenta East. "E está afetando os jovens, homens e mulheres." Montagem mostra exemplos de vídeos da trend “treinando caso ela diga não”, em que criadores simulam reações violentas após rejeição a pedidos de namoro ou casamento Reprodução/TikTok Outras indicações da pesquisa demonstram que, globalmente, 44% das pessoas concordam que "fomos longe demais ao promover a igualdade das mulheres e passamos a discriminar os homens". Segundo o organismo de defesa dos direitos das mulheres das Nações Unidas, nenhum país atingiu plena igualdade legal para mulheres e meninas. As mulheres detêm globalmente 64% dos direitos legais dos homens, "o que as expõem à discriminação, violência e exclusão em todas as fases da vida", declarou a UN Women. Penny East afirma que existe um "fenômeno crescente na percepção do público, de que a igualdade das mulheres já fez o necessário". Mas esta postura, segundo ela, "ignora as estatísticas nacionais que demonstram, infelizmente, que as mulheres ainda sofrem abusos nas suas próprias casas, continuam sendo importunadas sexualmente nas ruas e ainda ganham menos, em comparação com os homens". Projetos de lei contra misoginia no Congresso Em meio ao debate sobre misoginia e violência contra mulheres nas redes sociais, parlamentares têm apresentado propostas no Congresso Nacional para ampliar os instrumentos legais de enfrentamento a esse tipo de conteúdo. Na Câmara dos Deputados, a deputada federal Sâmia Bomfim (PSOL-SP) é autora de um projeto de lei que propõe a criminalização da misoginia e da disseminação de conteúdos associados à chamada cultura "red pill" na internet. A iniciativa busca responsabilizar publicações digitais que promovam ódio, violência, humilhação ou inferiorização das mulheres, sobretudo em redes sociais, fóruns e comunidades online que difundem ideologias misóginas. No exterior, vídeos com pessoas simulando golpes em resposta a uma rejeição feminina também viralizaram. Reprodução/TikTok No Senado, a Comissão de Direitos Humanos (CDH) deve analisar nos próximos dias um projeto que inclui a misoginia na Lei do Racismo (Lei nº 7.716/1989) e tipifica a prática como crime de discriminação. A proposta, apresentada pela senadora Ana Paula Lobato (PSB-MA), define misoginia como atos que manifestem ódio ou aversão às mulheres com base na ideia de supremacia masculina. Se aprovado, o texto prevê que a Lei do Racismo passe a punir também crimes praticados em razão de misoginia, ampliando o alcance da legislação atualmente aplicada a casos de discriminação por raça, cor, etnia, religião ou procedência nacional. * Com a colaboração de Iara Diniz